Skip to main content

LLM信息空间的映射

乘法

- 两个32bit的浮点数乘法,相当于32位的bit向量做空间映射

- 每个bit代表了特殊的含义,指数、尾数以及对应的档位

- 乘法不能充分利用32位的所有表达空间,精度越低的数据信息利用率越高

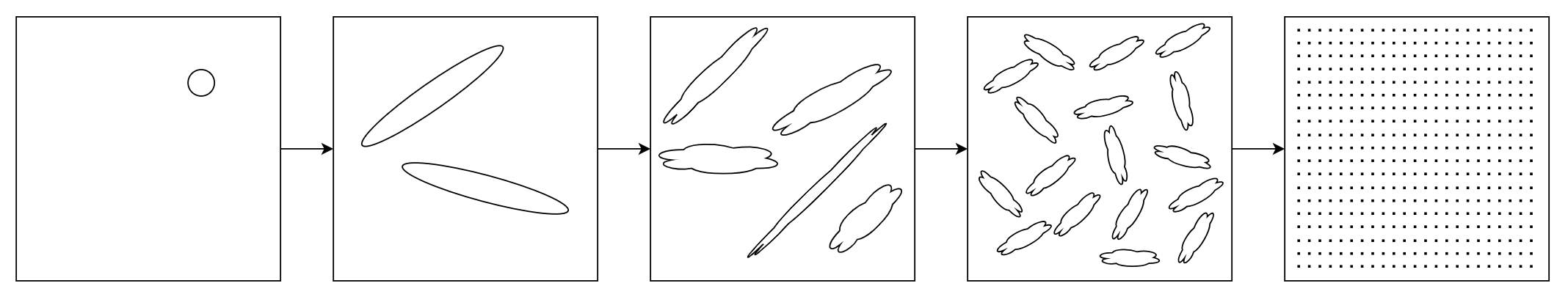

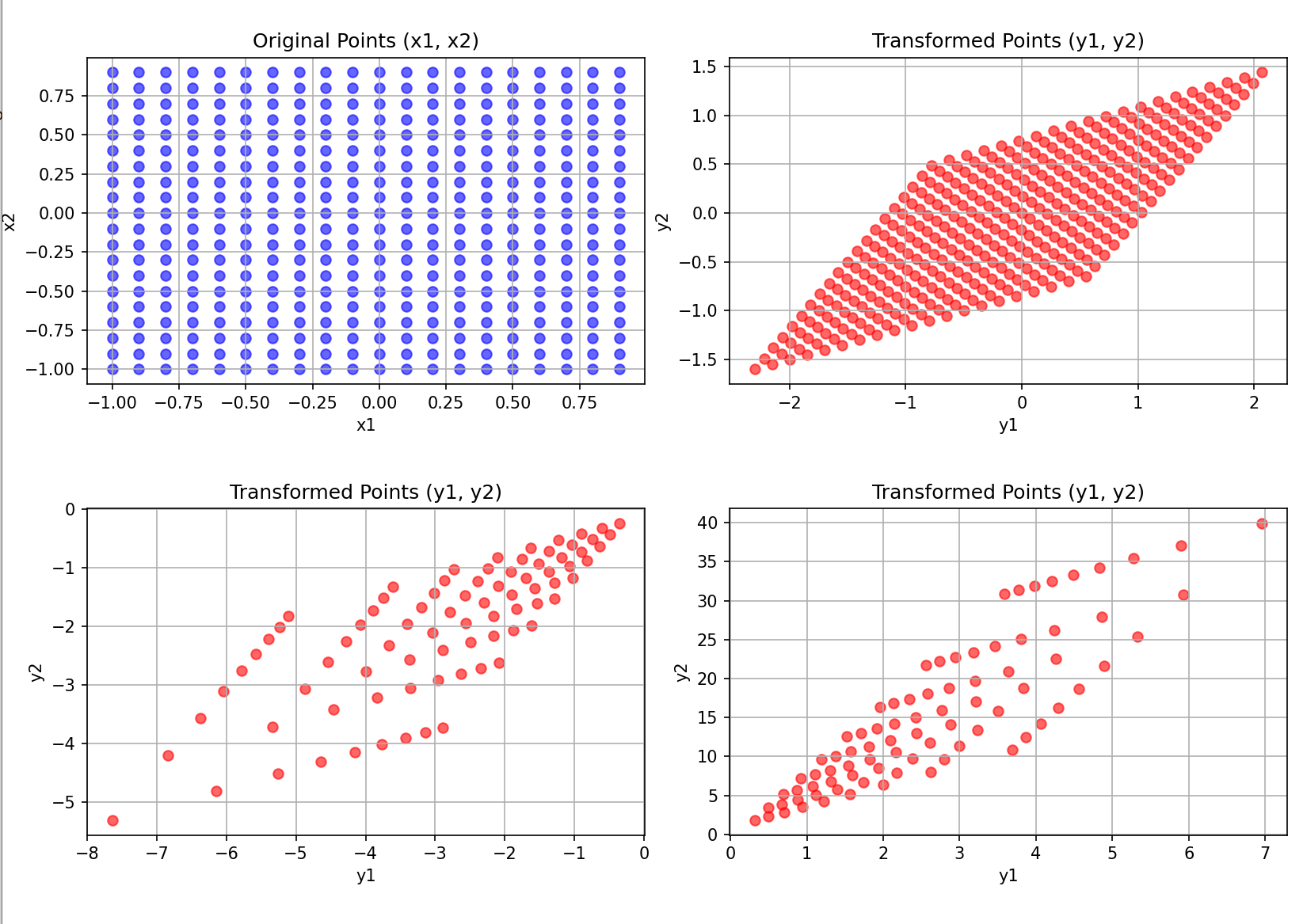

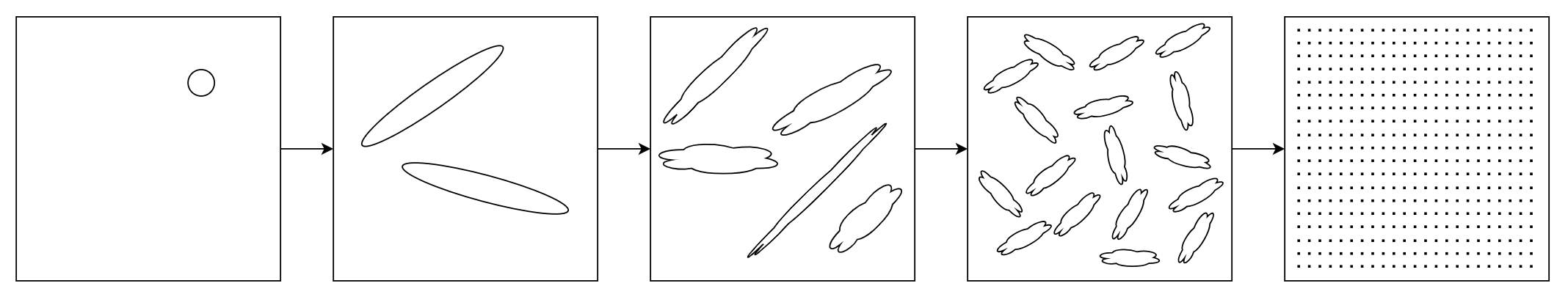

多层映射(等高线)

- 每一层的所有的hidden status的集合,表示了当前的所有信息(语义)

- 每经过一层相当于把一种向量空间的表示,映射到另外一个向量空间

- 每一次梯度下降都优化一点映射关系,增加不同类的距离,减少同类的距离

- 对输入的hidden status理解得越深刻(抽象得越高级),映射分隔得越准确,输出的结果越好

- 经过多次映射之后就能直接得到结果需要的index

- 非常大的线性映射的参数:DeekseekV3 671B中,大头(98%)参数是,256专家*60层*44MB=670GB

- 每个expert有三个linear,总参数量 = hidden_size * moe_intermediate_size * 3层 = 7168 * 2048 * 3 = 44MB

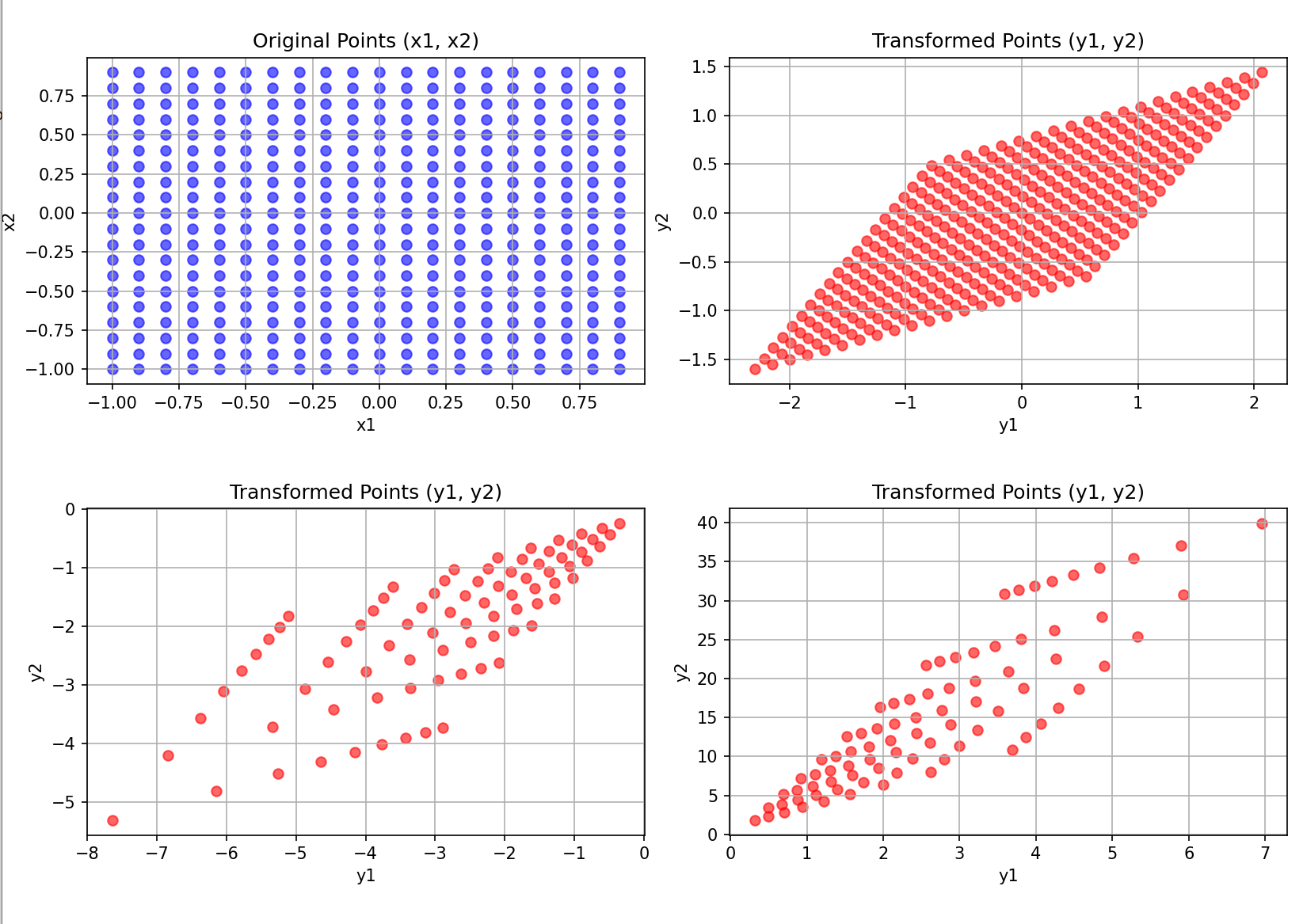

线性映射 非线性映射

非线性Dot

- 对B进行非线性映射,A = B *(C+D) 等价于 A = B*C + B*D ,ABCD都是矩阵

- 实际上增加了映射的空间灵活度,实验下来,使用得当可能可以提升精度

- ResNet的典型 A = B*C + B

- 显然D是1,不对B进行改变

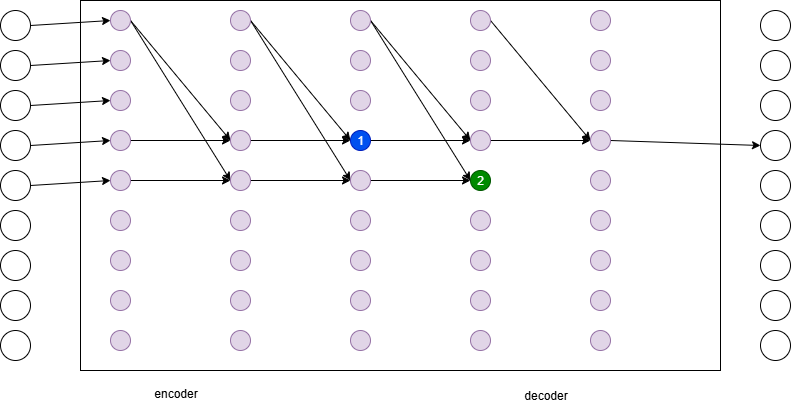

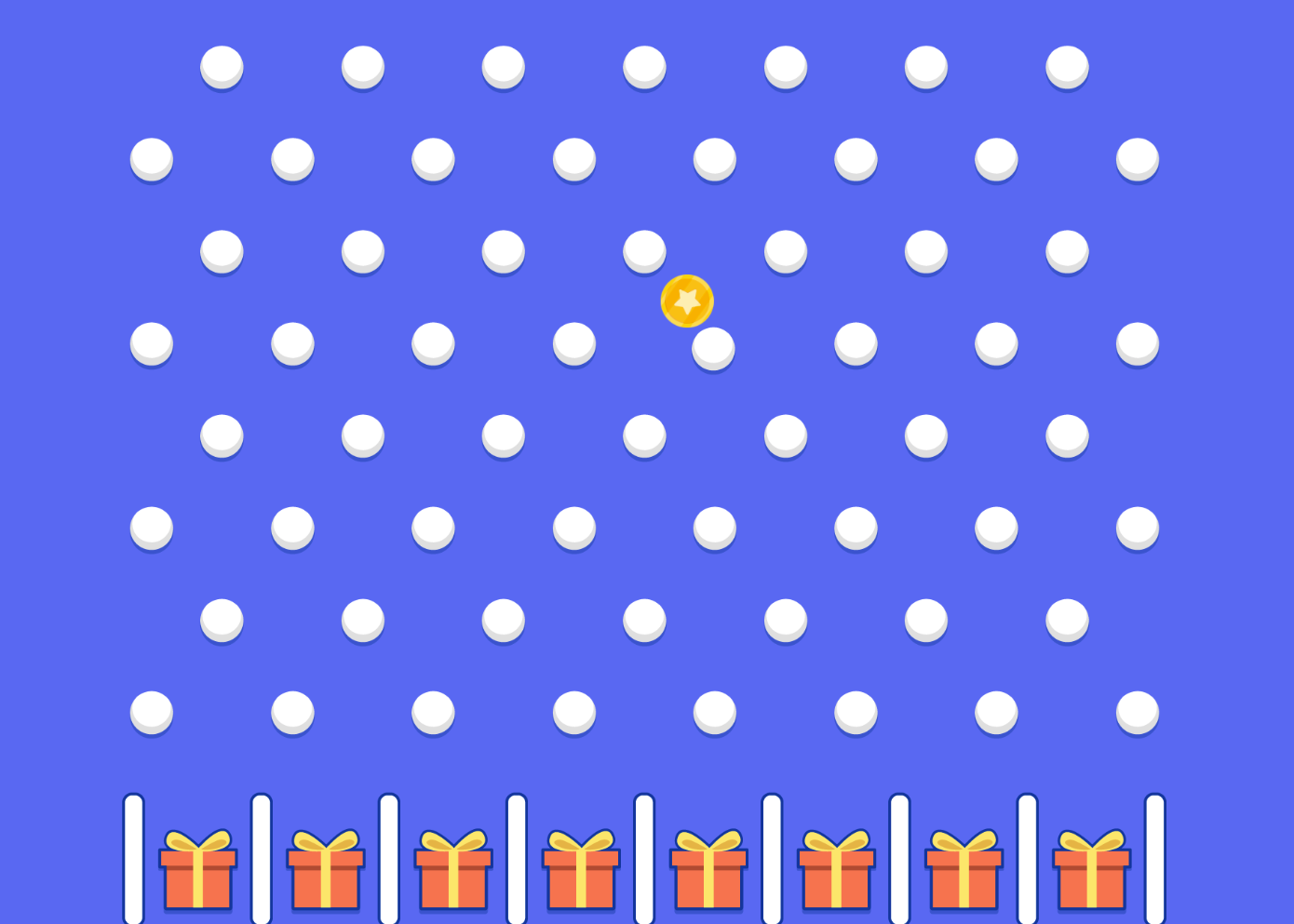

LLM的映射行为

- 每一层都根据前面的数据映射到另外一个表示空间

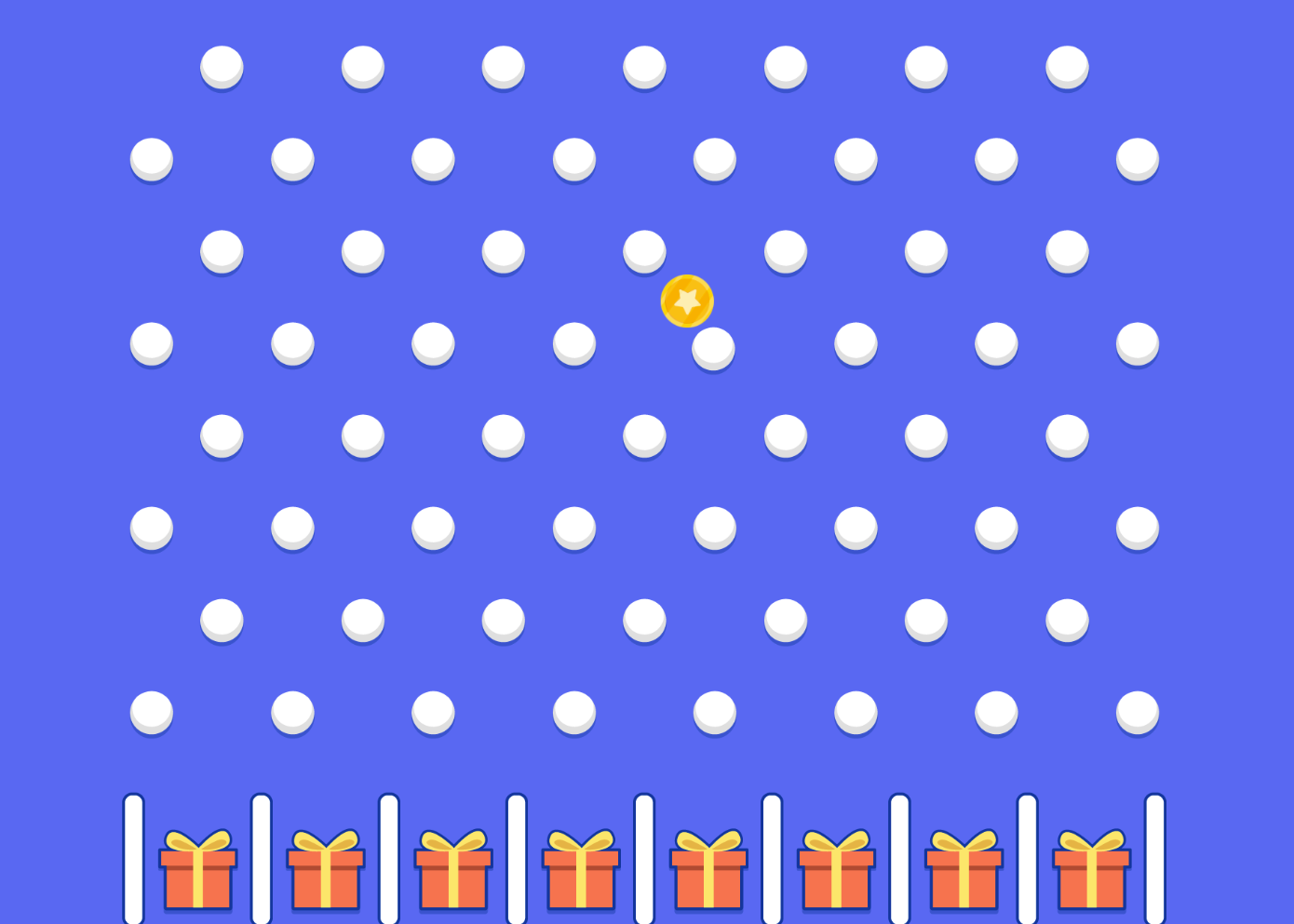

- 多层的LLM可以等价于一个大型卡罗搜索树

- 剪枝的,均匀宽度的

- 大规模参数,多维度

- 行为可以比喻为Plinko(中文常译为“钉板游戏”或“弹珠盘”)

- 从上到下不断在转换在对应空间内的分类

- 当前layer的所有token的所有hidden status的所有可能数值共同表示了所有的可能分类

- 最终的hidden status都对应了一个token

信息的表示

- 所有内部节点表示:同层的所有前面token的总结(映射)的结果

- 矛盾:既要表达当前节点的局部语义,又要表达到当前token的整体语义

No comments to display

No comments to display