LLM大语言模型的训练

预训练

继续预训练

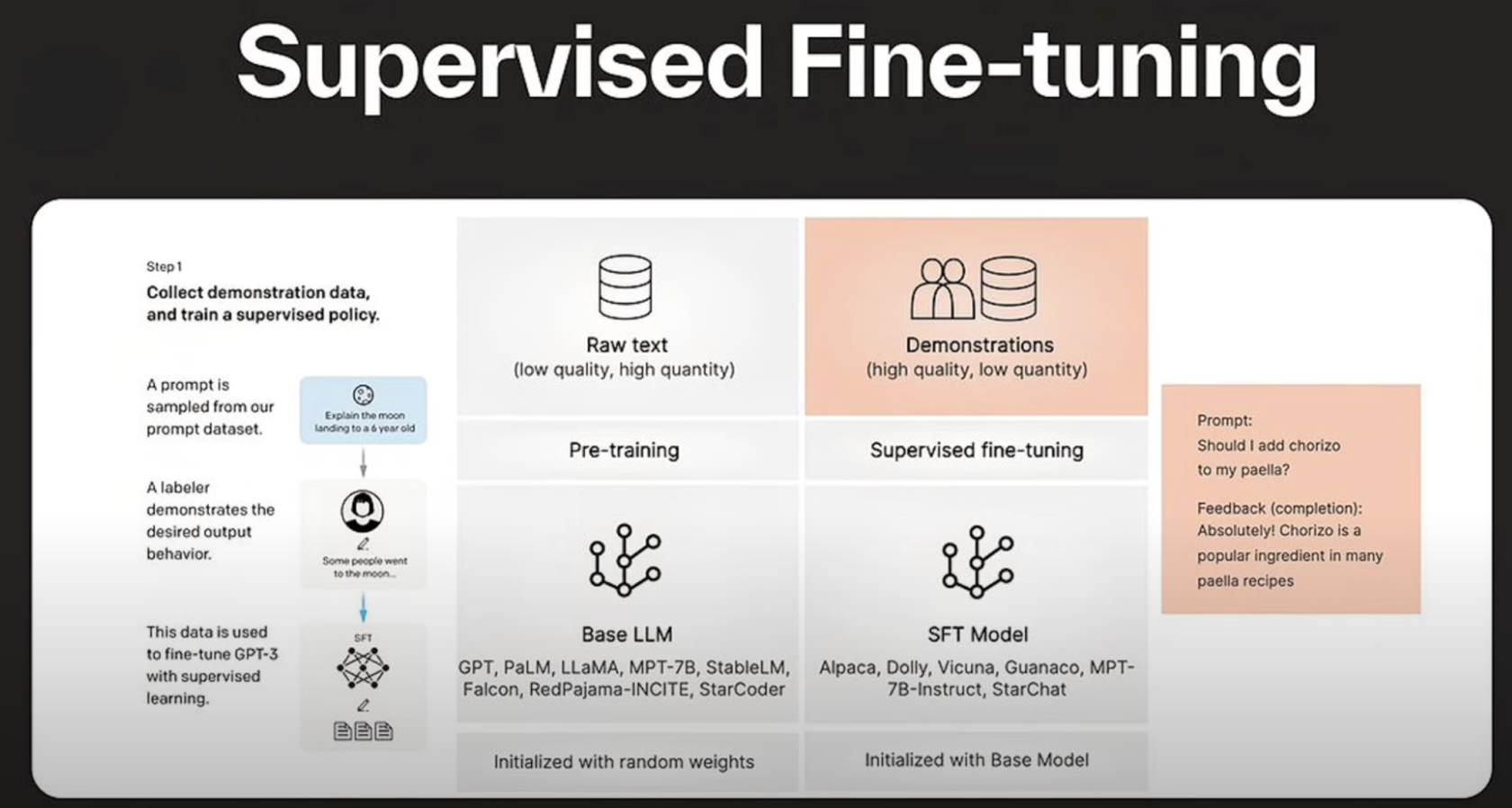

微调

- 全面微调更容易出现两个问题:模型崩溃和灾难性遗忘

- PEFT技术本质上,是作为微调的自然正则化器

- 数据集的质量和筛选,对微调的成功起着重要作用:一个大趋势是质量比数量更重要,拥有一小部分高质量的数据,比拥有一大批低质量的数据更好。

- 一致的注释,没有错误、没有错误标签的数据、有噪音的输入/输出

- 与总体相比具有代表性的分布

- 微调是大模型开发中的一个关键方面,需要在艺术和科学之间取得微妙的平衡。

强化学习-DeepSeek-R1

- 通过约束生成的内容和方式

- 通过问答的和逻辑分析的形式来约束模型的学习/训练/优化

- 使用自然语言作为接口,使得这个方式成为可能

- 引导模型使用更动态的方式(逻辑思维链)进行学习